به معنای یک نوجوان ایرانی ، نهایت استفاده ما از هوش مصنوعی با صدای صدا تقلید شده است. این تفسیر تلخ درست است. این جایی است که سایر کشورها در مناطق مختلف زندگی قابل توجه هستند.

به خصوص در سالهای اخیر ، استفاده نامنظم و سرگرمی صرف از هوش مصنوعی موجی از محتوای غیر واقعی را در فضای مجازی جابجا کرده است. به راحتی می توانید تصاویر ، صداها و وقایع شخصی زندگی بازیگران و خوانندگان را بدست آورید.

تقلید

از ویژگی های جدید هوش مصنوعی می توان برای ساخت تصاویر ، فیلم ها و صداها جعلی ساخت. چالش هایی که اصطلاح “جعل عمیق” را در دسته اخبار جعلی یا اخبار جعلی شکل داده است.

در “جعل عمیق” ، با استفاده از تصویر یا صدای مردم ، آنها یک نسخه جعلی را تهیه می کنند و صدایی را تولید می کنند که شخص هرگز صحبت نمی کند یا یک فیلم و عکسی از او می سازد که شخص هرگز چنین نبوده است. به طور کلی ، تولید محتوای جعلی برای افراد مشکل ساز است ، اما صدا و تصویر بیشتر از نوشتن متن است و حتی کسانی که حوصله ندارند متن ها را به راحتی می خوانند تا محتوای جعلی دیگر را ببینند و بشنوند ، و این محتوا در ذهن عمومی پایدار است.

از یک طرف ، دست به دست و دست و نشر هرگز به طور کامل نابود نخواهد شد و با یک جستجوی ساده می توان به آن دست یافت.

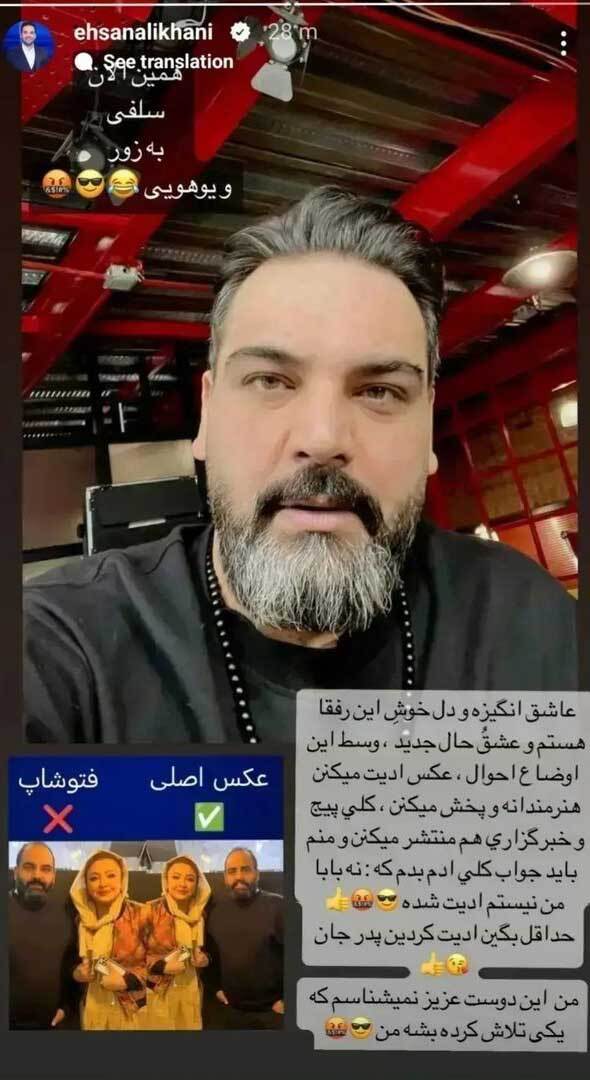

به عنوان مثال ، انتشار عکس جعلی Ehsan Alikhani در کنار Mehlqa Bagheri و همچنین دستکاری تصاویر Elnaz Shakirdoust در بستر بیمارستان و قرار دادن چهره آهنگ Alidousti در جای خود ، درست هنگامی که این بازیگر در بیمارستان بستری شد ، نمونه ای از استفاده از اطلاعات زرد است. موضوعی که Ehsan Alikhani را مجبور به پاسخگویی به داستانی در صفحه اینستاگرام خود کرد و می نویسد: “من عاشق انگیزه و قلب این رفقای و عشق جدید هستم ، در وسط این وضعیت ، عکس های ویرایش ، عکس اصلی و هنری از من و من یک عکس از فتوشاپ دارم و حداقل شما یک عکس دارم.

استفاده نامناسب از چهره و صدای Khosro Shakibai در مراسم افتتاحیه جشنواره فیلم فجر باعث شد تا خانواده Khosrow Shakibai از این هنرمند فقید انتقاد کنند.

پوریا شکیبای ، فرزند زنده خوسرو شکیبای ، ویدئویی را در فضای مجازی منتشر کرد که وی به دلیل ناراحتی مادرش یک پیام اعتراضی منتشر کرده بود و گفت که بهتر است در تولید چنین محتوا در کلمه و دانش باشد.

وی همچنین خاطرنشان كرد كه او و مادرش هیچ ارتباطی با او و مادرش ندارند و شاید اگر این اتفاق بیفتد ، بهتر بود كه كاری قابل قبول تر ایجاد كنیم.

چگونه می توان آن را تشخیص داد که یک اثر جعلی است؟

اگرچه از تقلید از صدای بازیگران زن و مرد ایرانی به کارات دیده می شود ، اما مهمترین آسیب به استفاده نادرست از هوش مصنوعی ، آسیب رساندن به حریم خصوصی و تضعیف شخصیت هنری و اجتماعی آنها است.

مردم برای سرگرمی از چنین شخصی در چنین مکانی که هرگز به پاهای او نرفته است ، تولید می کنند.

با این حال ، هوش مصنوعی یک ابزار تولید انسانی است و با بررسی محتوا می توان آن را جعلی کرد. می توانید از روشهای ذکر آن استفاده کنید.

2. رشد را با دقت نگاه کنید

بسیاری از تصاویر تولید شده توسط هوش مصنوعی در نگاه اول واقعی به نظر می رسند.

به همین دلیل اولین پیشنهاد ما نگاه کردن به تصویر است. برای انجام این کار ، تصویر را با بالاترین وضوح ممکن جستجو کرده و سپس جزئیات را بزرگنمایی کنید. بزرگ شدن تصویر ناسازگاری ها و خطاهایی را نشان می دهد که ممکن است در نگاه اول مشخص نشود.

تصویر تصویر را پیدا کنید

اگر مطمئن نیستید که یک تصویر واقعی است یا توسط هوش مصنوعی تولید می شود ، سعی کنید منبع را پیدا کنید.

با خواندن نظرات منتشر شده توسط سایر کاربران در زیر تصویر ممکن است بتوانید اطلاعاتی را در مورد محل ارسال تصویر مشاهده کنید یا ممکن است یک جستجوی عکس معکوس انجام دهید. برای انجام این کار ، تصویر را در ابزارهایی مانند Google Image Reverse Search ، Tineye یا Yandex بارگذاری کنید و ممکن است منبع تصویر اصلی را پیدا کنید. نتایج این جستجوها همچنین ممکن است پیوندهایی به واقعیت رسانه های معتبر نشان دهد.

به تناسب اندام توجه کنید

آیا افراد به تصویر کشیده تناسب اندام مناسب دارند؟ برای تصاویر تولید شده توسط هوش مصنوعی غیر معمول نیست تا در رابطه با تناسب اختلافاتی ایجاد کند. دستها ممکن است خیلی کوچک باشند یا انگشتان خیلی بلند باشند یا سر و انگشتان دست با بقیه بدن مطابقت نداشته باشد. به عنوان مثال ، در تصویر جعلی نشان داده شده است که پوتین در برابر جسم زانو می زند. با این حال ، با دقت مشاهده می شود که کفش زانو به طور نامناسب بزرگ و گسترده است. گوش ها نیز طولانی به نظر می رسند. سر نیمه پوشیده نیز بسیار بزرگ است و متناسب با سایر اندامهای بدن نیست.

2. مراقب خطاهای هوش مصنوعی معمول باشید

دستها در حال حاضر منبع اصلی خطاها در برنامه های تصویر هوش مصنوعی مانند Mid Journey یا Dall-E هستند. به عنوان مثال ، در تصویری که توسط پوتین منتشر شد ، افسر پلیس در سمت چپ وی ششم دارد! همچنین در تصویری که توسط پاپ فرانسیس منتشر شده است ، که جعلی است ، او فقط چهار انگشت در تصویر دارد و انگشتانش در سمت چپ غیرمعمول به نظر می رسد. این عکس ها جعلی هستند.

سایر خطاهای متداول در تصاویر تولید شده توسط هوش مصنوعی شامل افرادی با دندان های زیادی می شود. همچنین ، فریم های عینک هایی که به طرز عجیبی تغییر شکل داده اند که می توان در تصاویر ایجاد شده توسط هوش مصنوعی مشاهده کرد. همچنین ، در بسیاری از این تصاویر گوش ها دارای اشکال غیرواقعی هستند ، مانند تصویر جعلی جسم و چکمه ها. همچنین ، سطحی مانند گوشه های کلاه ایمنی باعث ایجاد مشکلاتی در برنامه های مبتنی بر هوش مصنوعی می شود ، و گاهی اوقات به نظر می رسد که تصویر مختل می شود ، همانطور که در تصویر بازداشت ادعایی پوتین است.

با این حال ، هنری آژدار ، متخصص هوش مصنوعی هشدار می دهد که نسخه های جدیدتری از برنامه هایی مانند سفر میانه در به تصویر کشیدن دست ها بهتر عمل می کنند. این بدان معنی است که کاربران در دراز مدت نمی توانند حساب ها را باز کنند.

2. آیا آنها مصنوعی و صاف به نظر می رسند؟

برنامه Mid Journey به طور خاص تصاویر بسیاری را ایجاد می کند که به نظر می رسد خیلی خوب هستند. احساس درونی خود را در اینجا دنبال کنید: آیا واقعاً می تواند چنین تصویری کامل با افراد بی عیب و نقص واقعی باشد؟ آندریاس دنگل از مرکز تحقیقات هوش مصنوعی آلمان گفت: “چهره ها بسیار خالص هستند و لباس هایی که نشان داده می شوند نیز بسیار هماهنگ هستند.” پوست افراد در بسیاری از تصاویر از هوش مصنوعی اغلب صاف و عاری از هرگونه سوزش است و حتی مو و دندان آنها بی عیب و نقص است. اینها معمولاً در زندگی واقعی کاربردی نیست.

بسیاری از تصاویر همچنین ظاهری هنری ، براق و پر زرق و برق دارند که حتی عکاسان حرفه ای نیز در دستیابی به عکاسی استودیویی مشکل دارند. غالباً ، به نظر می رسد ابزارهای مبتنی بر هوش مصنوعی تصاویر ایده آل را طراحی می کنند که قرار است کامل باشد و مردم را تا حد امکان خوشحال کند.

2. سپس قسمت را بررسی کنید

پیشینه یک تصویر اغلب می تواند نشان دهد که آیا دستکاری شده است یا خیر.

در اینجا نیز ، اشیاء می توانند تغییر شکل به نظر برسند. به عنوان مثال ، به چراغ های خیابانی توجه کنید. در چند مورد ، برنامه های هوش مصنوعی افراد و اشیاء را شبیه سازی می کنند و از آنها دو بار در یک تصویر استفاده می کنند و ناپدید شدن پیشینه تصاویر هوش مصنوعی غیر معمول نیست. اما حتی این تاری می تواند حاوی خطا باشد. پس زمینه به نظر مصنوعی مبهم است.

در نتیجه ، بسیاری از تصاویر تولید شده توسط هوش مصنوعی هنوز با برخی تحقیقات قابل یادآوری هستند. با این حال ، فناوری بهتر می شود و احتمالاً این اشتباهات در آینده نادر است.

کجا پناه ببرد؟

قوانین اطلاعاتی مصنوعی در ایران هنوز نمی تواند توسط فرد مجروح شکایت و پیگیری کند. به طور خاص ، هویت تولید کننده محتوا نامشخص است.

انگلیس ، اتحادیه اروپا و ایالات متحده سالهاست که برای تهیه و طراحی قوانین در مورد هوش مصنوعی لازم است. این توسط معاون رئیس جمهور علوم ، فناوری و اقتصاد رئیس جمهور اعلام شده است که مطالعات تطبیقی قوانین جهانی اطلاعات مصنوعی در ایران آغاز شده است. با این حال ، در حال حاضر هیچ خروجی خبری وجود ندارد.

امروز ، اگر عکس جعلی شما به همراه افرادی که در فضای مجازی نمی شناسید ، واقعاً قادر به کنترل آن نیست ، و آیا چنین پدیده فرهنگی مخرب به اندازه کافی ترسناک است که در مورد مکانیسم قانونی خود فکر کنید؟